Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường là một khái niệm cốt lõi trong lĩnh vực trí tuệ nhân tạo, nơi các tác nhân học hỏi qua quá trình tương tác với môi trường để tối ưu hóa hành vi. Phương pháp này không chỉ giúp máy tính đưa ra quyết định thông minh mà còn ứng dụng rộng rãi trong nhiều lĩnh vực từ trò chơi đến y tế, mang lại những đột phá đáng kể trong việc mô phỏng trí tuệ con người.

Giới thiệu về Học Tăng Cường

Học tăng cường, hay Reinforcement Learning, đại diện cho một nhánh quan trọng của học máy, nơi các hệ thống học hỏi từ phản hồi trực tiếp từ môi trường thay vì dữ liệu đã được gán nhãn sẵn. Phương pháp này mô phỏng cách con người học hỏi qua thử nghiệm, với mục tiêu tối đa hóa phần thưởng tích lũy. Trong bối cảnh phát triển nhanh chóng của AI, việc hiểu rõ về Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường không chỉ giúp làm sáng tỏ cơ chế hoạt động mà còn mở ra cơ hội ứng dụng thực tiễn đa dạng. Đoạn giới thiệu này sẽ dẫn dắt bạn qua các khía cạnh cơ bản, từ định nghĩa đến tầm quan trọng, nhằm xây dựng nền tảng vững chắc cho những phần sau.

Định nghĩa Học Tăng Cường

Học tăng cường là một phương pháp học máy mà ở đó, một tác nhân (agent) tương tác với môi trường để học hỏi và cải thiện hành vi của mình thông qua các phần thưởng hoặc hình phạt nhận được. Thay vì dựa vào dữ liệu lịch sử như trong học có giám sát, phương pháp này nhấn mạnh vào quá trình thử nghiệm và sai lầm, nơi tác nhân phải đưa ra quyết định trong điều kiện không chắc chắn. Ví dụ, trong một trò chơi, tác nhân có thể là một nhân vật robot học cách di chuyển để tránh chướng ngại vật, nhận phần thưởng khi đạt được mục tiêu và bị phạt khi mắc lỗi.

Quá trình này được mô tả bởi một vòng lặp liên tục: tác nhân quan sát trạng thái hiện tại của môi trường, chọn hành động, thực hiện hành động đó và nhận phản hồi dưới dạng phần thưởng. Điều làm nên sức hấp dẫn của Học tăng cường là khả năng xử lý các vấn đề phức tạp, nơi các quyết định của tác nhân ảnh hưởng đến tương lai, như trong các hệ thống tự lái hoặc quản lý tài nguyên. Không chỉ dừng lại ở lý thuyết, các thuật toán như Q-Learning đã chứng minh hiệu quả trong việc giúp tác nhân học hỏi chính sách tối ưu, từ đó nâng cao hiệu suất tổng thể.

Hơn nữa, định nghĩa Học tăng cường còn bao gồm khái niệm về chính sách (policy), là chiến lược mà tác nhân sử dụng để chọn hành động dựa trên trạng thái. Trong thực tế, Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường thường liên quan đến việc cân bằng giữa khám phá (exploration) và khai thác (exploitation), nghĩa là tác nhân phải thử nghiệm các hành động mới để học hỏi, đồng thời tận dụng kiến thức đã có để đạt phần thưởng ngay lập tức. Điều này tạo nên sự khác biệt so với các phương pháp học máy truyền thống, giúp AI trở nên linh hoạt hơn trong môi trường động.

Lịch sử phát triển của Học Tăng Cường

Lịch sử của Học tăng cường bắt đầu từ những năm 1950, khi các nhà khoa học như Alan Turing đã đề cập đến khái niệm máy học qua thử nghiệm trong các bài viết về trí tuệ nhân tạo. Đến những năm 1980, Richard Sutton và Andrew Barto đã công bố cuốn sách “Reinforcement Learning: An Introduction”, đánh dấu mốc quan trọng trong việc hệ thống hóa lý thuyết. Những phát triển ban đầu tập trung vào các thuật toán đơn giản như Q-Learning, được phát triển bởi Chris Watkins vào năm 1989, cho phép tác nhân học hỏi từ ma trận Q để ước lượng giá trị của các hành động.

Trong thập kỷ 1990 và 2000, lĩnh vực này chứng kiến sự bùng nổ nhờ sự kết hợp với mạng nơ-ron, dẫn đến sự ra đời của Deep Reinforcement Learning. Một ví dụ điển hình là thành công của DeepMind trong việc đánh bại con người ở trò chơi Go năm 2016 với AlphaGo, sử dụng các thuật toán như Deep Q-Networks. Sự phát triển này không chỉ nhờ vào sức mạnh tính toán mà còn từ các cải tiến về thuật toán, chẳng hạn như Policy Gradient Methods, giúp xử lý không gian hành động liên tục. Từ đó, Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường đã trở thành trọng tâm của nghiên cứu AI toàn cầu.

Ngày nay, lịch sử tiếp tục được viết bởi các ứng dụng thực tiễn, từ robot tự động hóa đến hệ thống giao dịch tài chính. Các công ty lớn như Google và OpenAI đã đầu tư mạnh mẽ, dẫn đến sự ra đời của các mô hình tiên tiến như Proximal Policy Optimization (PPO). Tuy nhiên, hành trình phát triển không thiếu thách thức, từ việc cải thiện tính ổn định của thuật toán đến ứng dụng trong môi trường thực tế, nhưng chính những bước tiến này đã khẳng định vị thế của Học tăng cường trong kỷ nguyên AI.

Tại sao Học Tăng Cường quan trọng trong AI?

Học tăng cường đóng vai trò then chốt trong AI vì nó cho phép các hệ thống học hỏi tự động mà không cần dữ liệu huấn luyện khổng lồ, chỉ dựa vào tương tác trực tiếp với môi trường. Trong bối cảnh AI ngày càng hướng tới việc giải quyết các vấn đề thực tế, phương pháp này giúp tạo ra các tác nhân thông minh, có khả năng thích ứng với sự thay đổi, như trong hệ thống điều khiển robot hoặc tối ưu hóa logistics. Ví dụ, trong ngành công nghiệp, Học tăng cường có thể tối ưu hóa quy trình sản xuất, giảm chi phí và tăng hiệu quả, chứng tỏ giá trị vượt trội so với các kỹ thuật học máy truyền thống.

Một lý do quan trọng khác là khả năng xử lý các vấn đề ra quyết định dài hạn, nơi các hành động hiện tại ảnh hưởng đến kết quả tương lai. Điều này làm cho Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường trở thành công cụ thiết yếu trong AI, đặc biệt trong lĩnh vực tự động hóa và học sâu. Các thuật toán như Actor-Critic Methods đã chứng minh khả năng học nhanh chóng từ phản hồi, giúp AI vượt qua giới hạn của học có giám sát, nơi dữ liệu phải được chuẩn bị kỹ lưỡng. Hơn nữa, sự phát triển của Học tăng cường thúc đẩy đổi mới trong các lĩnh vực khác, như xử lý ngôn ngữ tự nhiên hoặc nhận diện hình ảnh.

Tóm lại, Học tăng cường quan trọng vì nó mang lại khả năng học tập linh hoạt, giúp AI tiến gần hơn với trí tuệ con người. Trong tương lai, với sự kết hợp giữa Học tăng cường và các công nghệ mới như học liên tục (continual learning), lĩnh vực AI sẽ tiếp tục phát triển, mở ra cơ hội cho các ứng dụng đột phá và giải quyết các vấn đề toàn cầu.

Các thành phần chính của Học Tăng Cường

Các thành phần chính của Học tăng cường tạo nên nền tảng cho sự hoạt động hiệu quả của các thuật toán, bao gồm môi trường, tác nhân, hành động, phần thưởng và chính sách. Những yếu tố này không chỉ định hình cách mà hệ thống học hỏi mà còn ảnh hưởng trực tiếp đến kết quả cuối cùng. Trong phần này, chúng ta sẽ khám phá sâu hơn về cách mà Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường phụ thuộc vào sự hài hòa giữa các thành phần này để đạt được mục tiêu tối ưu.

Môi trường (Environment)

Môi trường trong Học tăng cường là không gian mà tác nhân tương tác, cung cấp thông tin về trạng thái hiện tại và phản hồi lại các hành động. Nó được mô tả như một hệ thống động, nơi mỗi trạng thái dẫn đến các trạng thái mới dựa trên hành động của tác nhân. Ví dụ, trong một trò chơi điện tử, môi trường có thể là màn chơi với các vật cản và mục tiêu, ảnh hưởng trực tiếp đến quá trình học hỏi.

Môi trường không chỉ phản hồi mà còn định nghĩa mức độ phức tạp của bài toán, chẳng hạn như trong các hệ thống thực tế như giao thông đô thị, nơi có yếu tố ngẫu nhiên như thời tiết hoặc lưu lượng xe cộ. Điều này yêu cầu thuật toán phải xử lý sự không chắc chắn, làm cho việc hiểu rõ môi trường trở thành yếu tố then chốt trong việc áp dụng Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường.

Ngoài ra, môi trường còn liên quan đến khái niệm Markov Decision Process (MDP), nơi trạng thái tiếp theo chỉ phụ thuộc vào trạng thái hiện tại và hành động, giúp tối ưu hóa quá trình học. Sự thiết kế môi trường tốt có thể đẩy nhanh tốc độ hội tụ của thuật toán, từ đó nâng cao hiệu quả tổng thể.

Tác nhân (Agent)

Tác nhân là trung tâm của Học tăng cường, chịu trách nhiệm quan sát, quyết định và học hỏi từ môi trường. Nó được trang bị các chính sách để chọn hành động dựa trên trạng thái hiện tại, nhằm tối đa hóa phần thưởng tích lũy. Trong thực tế, tác nhân có thể là một robot trong nhà máy, học cách tránh va chạm để hoàn thành nhiệm vụ.

Quá trình học của tác nhân bao gồm việc cập nhật kiến thức từ phản hồi, sử dụng các thuật toán như Q-Learning để ước lượng giá trị của hành động. Điều này làm cho tác nhân trở nên thông minh hơn theo thời gian, thích ứng với thay đổi trong môi trường. Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường nhấn mạnh rằng tác nhân phải cân bằng giữa khám phá và khai thác để tránh rơi vào trạng thái cục bộ.

Hơn nữa, trong các ứng dụng phức tạp, tác nhân có thể sử dụng mạng nơ-ron để xử lý dữ liệu lớn, như trong Deep Reinforcement Learning, giúp cải thiện khả năng tổng quát hóa và áp dụng vào các tình huống mới.

Hành động (Actions)

Hành động là các lựa chọn mà tác nhân thực hiện để tương tác với môi trường, có thể là rời rạc như di chuyển trái/phải hoặc liên tục như điều chỉnh tốc độ. Chúng đóng vai trò quyết định trong việc dẫn dắt hệ thống đến phần thưởng mong muốn. Ví dụ, trong hệ thống giao dịch chứng khoán, hành động có thể là mua hoặc bán cổ phiếu dựa trên phân tích thị trường.

Mỗi hành động đều có hậu quả, ảnh hưởng đến chuỗi sự kiện tiếp theo, đòi hỏi thuật toán phải dự đoán giá trị dài hạn. Điều này làm cho việc thiết kế không gian hành động trở nên quan trọng trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường.

Ngoài ra, hành động còn liên quan đến chính sách, nơi tác nhân học để chọn hành động tối ưu, giúp tránh các quyết định sai lầm và tối đa hóa hiệu quả học tập.

Phần thưởng (Rewards) và Chính sách (Policy)

Phần thưởng là tín hiệu phản hồi mà tác nhân nhận được sau mỗi hành động, đóng vai trò như động lực để học hỏi. Nó có thể dương hoặc âm, giúp tác nhân phân biệt giữa hành vi tốt và xấu. Ví dụ, trong đào tạo AI chơi cờ vua, phần thưởng cao được trao khi thắng trận.

Chính sách, mặt khác, là quy tắc mà tác nhân sử dụng để chọn hành động, có thể là deterministic hoặc stochastic. Sự kết hợp giữa phần thưởng và chính sách làm cho hệ thống trở nên hiệu quả hơn, như trong các thuật toán Policy Gradient.

Cùng với đó, phần thưởng phải được thiết kế cẩn thận để tránh các vấn đề như phần thưởng sparse, nơi phản hồi không thường xuyên, ảnh hưởng đến quá trình học. Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường phụ thuộc vào sự hài hòa này để đạt kết quả tối ưu.

Các thuật toán Học Tăng Cường phổ biến

Các thuật toán Học tăng cường là công cụ then chốt để triển khai các ứng dụng thực tế, từ Q-Learning cơ bản đến các phương pháp tiên tiến như PPO. Chúng giúp giải quyết các vấn đề phức tạp bằng cách tối ưu hóa chính sách và ước lượng giá trị. Để minh họa, dưới đây là một bảng so sánh ngắn gọn về các thuật toán phổ biến, nhấn mạnh vào ưu điểm, nhược điểm và ứng dụng:

| Thuật toán | Ưu điểm | Nhược điểm | Ứng dụng chính |

|---|---|---|---|

| Q-Learning | Dễ triển khai, học từ kinh nghiệm | Không hiệu quả với không gian lớn | Trò chơi đơn giản |

| Deep Q-Networks | Xử lý không gian trạng thái lớn | Yêu cầu dữ liệu lớn | Chơi game phức tạp |

| Policy Gradient | Tối ưu hóa trực tiếp chính sách | Có thể không ổn định | Robot và điều khiển |

| Actor-Critic | Kết hợp ưu điểm của hai loại | Cần cân bằng tham số | Học sâu trong AI |

| PPO | Ổn định và hiệu quả cao | Tính toán phức tạp | Ứng dụng thực tế như tự lái |

Bảng trên giúp làm rõ sự đa dạng của các thuật toán, hỗ trợ việc lựa chọn phù hợp. Tiếp theo, chúng ta sẽ đi sâu vào từng thuật toán để hiểu rõ hơn về cách chúng hoạt động trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường.

Q-Learning

Q-Learning là một thuật toán cơ bản trong Học tăng cường, sử dụng bảng Q để ước lượng giá trị của các hành động trong từng trạng thái. Thuật toán này hoạt động bằng cách cập nhật giá trị Q dựa trên công thức Bellman, giúp tác nhân học chính sách tối ưu mà không cần biết mô hình môi trường. Trong thực tế, Q-Learning thường được áp dụng trong các môi trường rời rạc, như trò chơi cờ caro.

Một ưu điểm lớn của Q-Learning là khả năng hội tụ đến giải pháp tối ưu, ngay cả trong môi trường stochastic. Tuy nhiên, nó gặp khó khăn khi đối mặt với không gian trạng thái lớn, dẫn đến vấn đề “khủng hoảng chiều” (curse of dimensionality). Điều này khiến các nhà nghiên cứu phải cải tiến, ví dụ bằng cách kết hợp với mạng nơ-ron để tạo thành Deep Q-Networks.

Ngoài ra, Q-Learning yêu cầu sự cân bằng giữa tỷ lệ khám phá và khai thác, thường sử dụng epsilon-greedy strategy. Trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, Q-Learning là bước đệm quan trọng để hiểu các khái niệm cốt lõi như phần thưởng tích lũy và chính sách.

Deep Q-Networks (DQN)

Deep Q-Networks kết hợp Q-Learning với mạng nơ-ron sâu, cho phép xử lý các không gian trạng thái liên tục và phức tạp. Thuật toán này sử dụng kỹ thuật experience replay để lưu trữ và lấy mẫu kinh nghiệm, giúp ổn định quá trình học và tránh vòng lặp phản hồi. Ví dụ, DQN đã được sử dụng trong trò chơi Atari, nơi AI học để chơi tốt hơn con người.

DQN không chỉ cải thiện hiệu suất mà còn giải quyết vấn đề của Q-Learning truyền thống bằng cách sử dụng hàm giá trị Q được học bởi mạng nơ-ron. Tuy nhiên, nó đòi hỏi tài nguyên tính toán lớn và có nguy cơ overfitting nếu không được huấn luyện đúng cách. Trong bối cảnh Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, DQN đại diện cho sự tiến bộ trong việc áp dụng học sâu.

Hơn nữa, các biến thể của DQN, như Double DQN, giúp giảm thiểu lỗi ước lượng, làm cho thuật toán trở nên đáng tin cậy hơn trong các ứng dụng thực tế.

Policy Gradient Methods

Policy Gradient Methods tập trung vào việc tối ưu hóa trực tiếp chính sách của tác nhân, sử dụng gradient descent để cập nhật tham số. Thuật toán này phù hợp với không gian hành động liên tục, như trong robot di chuyển, nơi cần dự đoán hành động chính xác. Ưu điểm lớn là khả năng xử lý các vấn đề phức tạp mà không cần bảng Q.

Tuy nhiên, Policy Gradient có thể gặp vấn đề không ổn định, dẫn đến sự suy giảm hiệu suất nếu gradient không chính xác. Để khắc phục, các kỹ thuật như baseline subtraction được sử dụng. Trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, Policy Gradient mở ra cánh cửa cho các ứng dụng đòi hỏi tính linh hoạt cao.

Cuối cùng, sự kết hợp Policy Gradient với các phương pháp khác đã tạo nên các thuật toán lai, nâng cao khả năng học tập tổng quát.

Actor-Critic Methods

Actor-Critic Methods kết hợp ưu điểm của Policy Gradient và Q-Learning, với “Actor” để chọn hành động và “Critic” để đánh giá giá trị. Điều này giúp thuật toán học nhanh hơn và ổn định hơn trong môi trường động. Ví dụ, trong hệ thống tự lái, Actor-Critic có thể điều chỉnh hành động lái xe dựa trên đánh giá của Critic.

Một lợi ích lớn là khả năng xử lý cả không gian rời rạc và liên tục, làm cho nó trở nên linh hoạt. Tuy nhiên, việc cân bằng giữa Actor và Critic đòi hỏi tinh chỉnh tham số cẩn thận. Trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, Actor-Critic là ví dụ điển hình của sự tiến hóa thuật toán.

Ngoài ra, các biến thể như A3C (Asynchronous Actor-Critic) tận dụng tính toán song song để tăng tốc độ học, chứng tỏ tiềm năng trong các ứng dụng quy mô lớn.

Áp dụng Học Tăng Cường trong thực tế

Áp dụng Học tăng cường trong thực tế đã mang lại những thay đổi lớn lao, từ trò chơi điện tử đến y tế, chứng minh sức mạnh của phương pháp này trong việc giải quyết vấn đề thực tế. Với Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, chúng ta có thể thấy cách các thuật toán được sử dụng để tối ưu hóa quyết định trong môi trường phức tạp, mang lại lợi ích kinh tế và xã hội to lớn.

Trò chơi điện tử

Trong trò chơi điện tử, Học tăng cường được sử dụng để tạo ra các AI thông minh, có khả năng học và thích ứng với chiến lược của người chơi. Ví dụ, AlphaGo của DeepMind đã đánh bại cao thủ Go, sử dụng DQN để phân tích hàng triệu nước đi. Điều này không chỉ nâng cao trải nghiệm chơi game mà còn thúc đẩy phát triển công nghệ.

Một ứng dụng khác là trong các trò chơi như Dota 2, nơi AI học để hợp tác với đồng đội, chứng minh khả năng xử lý môi trường đa tác nhân. Tuy nhiên, thách thức nằm ở việc đảm bảo AI không gian lận hoặc lạm dụng tài nguyên. Trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, lĩnh vực này là minh chứng cho sự kết hợp giữa giải trí và khoa học.

Hơn nữa, Học tăng cường giúp phát triển các công cụ thiết kế game, như tối ưu hóa mức độ khó để phù hợp với người chơi.

Robotics

Ứng dụng trong robotics giúp robot học cách thực hiện nhiệm vụ một cách tự động, chẳng hạn như di chuyển trong không gian chật hẹp. Sử dụng PPO, robot có thể học từ va chạm và điều chỉnh hành vi để tránh lỗi. Điều này đặc biệt quan trọng trong ngành công nghiệp, nơi robot thay thế con người trong các công việc nguy hiểm.

Một ví dụ là robot Boston Dynamics, sử dụng Học tăng cường để cải thiện khả năng cân bằng và di chuyển. Tuy nhiên, thách thức lớn là đảm bảo an toàn và tính chính xác trong môi trường thực tế. Trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, robotics đại diện cho sự giao thoa giữa AI và kỹ thuật.

Cuối cùng, các ứng dụng trong y tế, như robot phẫu thuật, mở ra tiềm năng mới cho Học tăng cường.

Tài chính và Giao dịch chứng khoán

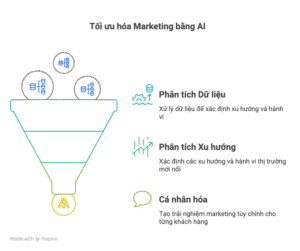

Trong tài chính, Học tăng cường tối ưu hóa giao dịch bằng cách dự đoán xu hướng thị trường và đưa ra quyết định mua bán. Thuật toán như Actor-Critic giúp hệ thống học từ dữ liệu lịch sử để giảm rủi ro. Ví dụ, các quỹ đầu tư sử dụng AI để đạt lợi nhuận cao hơn.

Tuy nhiên, thách thức là sự biến động của thị trường, đòi hỏi thuật toán phải học liên tục. Trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, lĩnh vực này nhấn mạnh vai trò của AI trong kinh tế số.

Ngoài ra, Học tăng cường còn được dùng để phát hiện gian lận tài chính, nâng cao an ninh hệ thống.

Y tế

Ứng dụng trong y tế bao gồm việc tối ưu hóa điều trị, như sử dụng Học tăng cường để dự đoán liều thuốc phù hợp cho bệnh nhân. Điều này giúp cải thiện kết quả điều trị và giảm thiểu rủi ro. Ví dụ, AI có thể học từ dữ liệu bệnh án để đề xuất kế hoạch chăm sóc.

Một thách thức lớn là bảo mật dữ liệu và đạo đức y tế. Trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, y tế là lĩnh vực quan trọng để cứu sống con người.

Hơn nữa, Học tăng cường hỗ trợ trong chẩn đoán hình ảnh, giúp bác sĩ đưa ra quyết định nhanh chóng.

Thách thức và tương lai của Học Tăng Cường

Thách thức và tương lai của Học tăng cường phản ánh sự phát triển không ngừng của lĩnh vực này, từ vấn đề ổn định đến các ứng dụng đạo đức. Với Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, chúng ta cần đối mặt với những hạn chế hiện tại để mở ra cơ hội mới, đảm bảo rằng công nghệ này mang lại lợi ích lâu dài cho xã hội.

Vấn đề tính ổn định và hiệu suất

Vấn đề tính ổn định thường xảy ra do sự biến động trong quá trình học, dẫn đến hiệu suất không đồng đều. Các thuật toán như PPO đã cải thiện điều này, nhưng vẫn cần nghiên cứu thêm. Trong thực tế, điều này ảnh hưởng đến ứng dụng trong môi trường thực tế.

Một cách tiếp cận là sử dụng kỹ thuật regularization để tăng cường ổn định. Tuy nhiên, hiệu suất vẫn bị ảnh hưởng bởi kích thước dữ liệu. Trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, việc giải quyết vấn đề này là chìa khóa cho sự phát triển.

Cuối cùng, tương lai có thể thấy sự kết hợp với học liên tục để duy trì hiệu suất cao.

Khả năng mở rộng trong môi trường phức tạp

Khả năng mở rộng là thách thức lớn khi áp dụng vào môi trường phức tạp, như hệ thống mạng lưới lớn. Thuật toán cần xử lý dữ liệu khổng lồ mà không mất hiệu quả. Ví dụ, trong robotics, mở rộng đòi hỏi tích hợp với các cảm biến thực tế.

Một giải pháp là sử dụng học phân tán, nhưng điều này tăng phức tạp. Trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, mở rộng là yếu tố quyết định cho các ứng dụng quy mô lớn.

Hơn nữa, tương lai sẽ chứng kiến sự cải tiến với công nghệ đám mây.

Đạo đức và trách nhiệm trong ứng dụng Học Tăng Cường

Đạo đức là vấn đề nổi bật, đặc biệt trong ứng dụng như AI quân sự, nơi có nguy cơ lạm dụng. Các nhà nghiên cứu cần đảm bảo tính minh bạch và trách nhiệm. Ví dụ, trong y tế, AI phải tuân thủ các tiêu chuẩn đạo đức để tránh sai lầm.

Thách thức nằm ở việc cân bằng giữa lợi ích và rủi ro. Trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, đạo đức là nền tảng cho sự chấp nhận rộng rãi.

Cuối cùng, tương lai sẽ tập trung vào quy định pháp lý để bảo vệ xã hội.

Xu hướng nghiên cứu và phát triển tiếp theo

Xu hướng nghiên cứu bao gồm học đa tác nhân và tích hợp với học không giám sát. Điều này mở ra cơ hội cho các ứng dụng mới. Ví dụ, kết hợp với NLP để tạo AI trò chuyện thông minh hơn.

Tuy nhiên, thách thức là nguồn lực và hợp tác quốc tế. Trong Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường, các xu hướng này sẽ định hình tương lai AI.

Kết luận

Tóm lại, Reinforcement Learning là gì? Thuật toán và các trường hợp học tăng cường đã được khám phá qua định nghĩa, thành phần, thuật toán, ứng dụng, thách thức và tương lai, nhấn mạnh vai trò quan trọng của nó trong trí tuệ nhân tạo. Từ Q-Learning đến các ứng dụng trong robotics và y tế, phương pháp này không chỉ giúp tối ưu hóa quyết định mà còn mở ra cơ hội đổi mới, dù vẫn đối mặt với các vấn đề như ổn định và đạo đức. Với sự phát triển liên tục, Học tăng cường sẽ tiếp tục dẫn dắt sự tiến bộ của AI, mang lại lợi ích to lớn cho nhân loại.